突出:

- YOLOv10 是最先进的实时对象检测模型。

- NVIDIA Jetson Orin 是一个功能强大的嵌入式平台,用于实时对象检测。

- Jetson-examples 是一个工具包,旨在在 NVIDIA Jetson 设备上部署容器化应用程序,包括计算机视觉和生成式 AI。

YOLOv10 简介

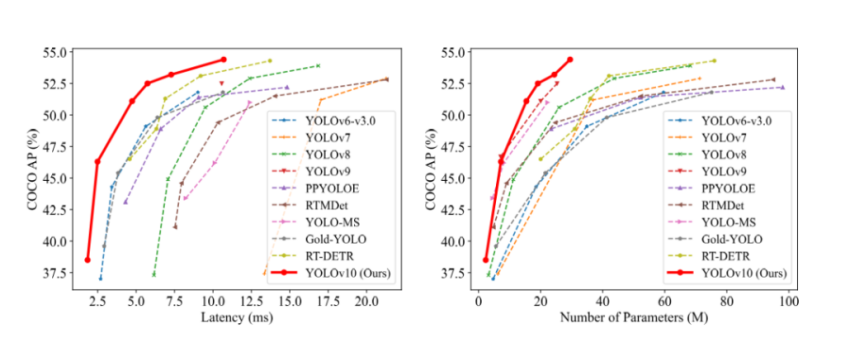

YOLOv10 由清华大学的研究人员开发,引入了一种革命性的实时对象检测方法,解决了以前 YOLO 版本在后处理和模型架构方面的局限性。通过消除非极大值抑制 (NMS) 和优化各种模型组件,YOLOv10 在不同模型尺度上实现了最先进的性能和效率。例如,COCO 上的 YOLOv10-S 比 RT-DETR-R18 快 1.8 倍,同时将参数和 FLOP 降低了 2.8 倍。与 YOLOv9-C 相比,YOLOv10-B 在性能相同的情况下,延迟降低 46%,参数降低 25%。

模型架构和性能

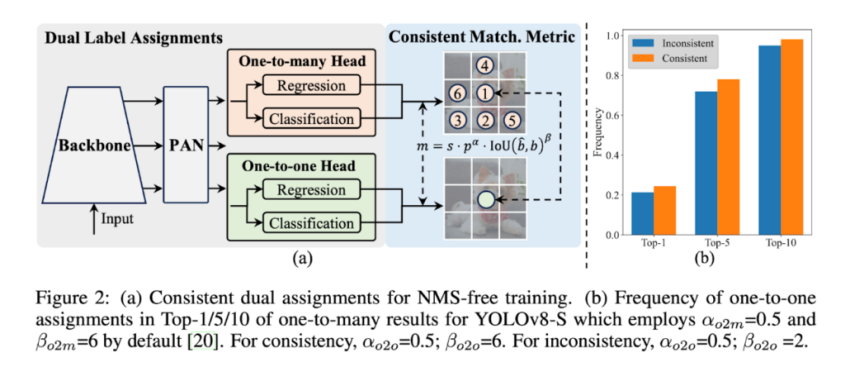

YOLOv10 从 YOLOv8 中被选中,因为它具有值得称道的延迟-精度平衡和各种模型大小的可用性,它利用一致的双重分配来实现无 NMS 训练和整体效率准确性驱动的模型设计。这种方法提高了 YOLOv10 模型的效率和准确性。

主要比较:

YOLOv10:YOLOv10 设计为实时端到端对象检测模型,其速度明显优于其前身。它在 COCO 数据集等基准上实现了高性能,同时保持了较少的参数数量,从而提高了其效率。

YOLOv8:YOLOv8 由 Ultralytics 开发,以其最先进的对象检测和图像分割功能而闻名。它在各种计算机视觉任务的准确性和稳健性方面表现出色,但速度无法与 YOLOv10 相提并论。

速度和效率:

YOLOv10:它的优化使其能够更快地处理图像,使其成为实时应用程序的理想选择。这种速度优势是在不显著增加参数的情况下实现的,从而确保模型保持轻量级和高效。

YOLOv8:虽然效率很高,但它更注重高精度和健壮性,有时以牺牲处理速度为代价。

YOLOv10 是如何实现如此快速的?

主要特点:

无 NMS 训练:利用一致的双重分配来消除对 NMS 的需求,从而减少推理延迟。

整体模型设计:从效率和精度角度对组件进行全面优化,包括轻量级分类头、空间通道解耦采样和等级导向块设计。

增强的模型功能:整合大核卷积和部分自我注意模块,以提高性能,而不会产生显著的计算成本。

只需一分钟即可在边缘轻松部署 YOLOv10!

Jetson-example 提供单线部署项目和边缘 AI 应用程序,包括 Ollama 和 Llama3 等生成式 AI 模型,以及 YOLOv8 和 YOLOv10 等计算机视觉模型。我们已经为您预先配置了所有环境,以启用项目的单命令部署。

使用 jetson-examples 进行部署:https://github.com/Seeed-Projects/jetson-examples/blob/main/reComputer/scripts/yolov10/README.md

入门步骤:

- 从 Seeed 获取 Jetson Orin 设备;我们的全系统设备是使用 Jetpack 预先构建的。

- 使用以下命令安装 jetson-examples 工具包: 。pip3 install jetson-examples

- 运行 YOLOv10 模型。

- 通过 Web UI 检查实时推理结果。

注意:为了获得自定义模型的最佳性能,我们强烈建议使用 TensorRT 来加速模型,以适应物理世界中的任务要求。了解如何在 Jetson 上使用 TensorRT 和 DeepStream SDK 支持:使用 DeepStream SDK 的 TensorRT。

在 NVIDIA Jetson Orin 上轻松部署 YOLOv10,并利用其实时、端到端的对象检测功能来高效地支持您的边缘 AI 应用程序!

点击下方链接即可了解详情下单!

NVIDIA品牌专区: https://s.iceasy.com/1uJAEX

NVIDIA Jetson Orin Nano 开发套件: https://www.iceasy.com/3324/1023765525.shtml

Jetson AGX Orin 64GB开发套件: https://www.iceasy.com/3324/1023765525.shtml

NVIDIA教育优惠申请链接: https://s.iceasy.com/1rtWpmx